おはようございます。

まだまだ、みなさんに伝えたい話はいっぱいあります。

でも、授業という枠の中では今回が最終回になります。

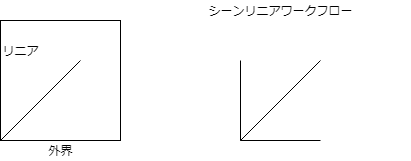

一応、本日はシーンリニアワークフローを話します。

Scene Lenear Workflow シーンリニアワークフロー

デジタル映像を考えるときに忘れてはいけない概念のひとつが「色」に関してです。

フィルムの場合、色の再現性は非常に高く、高いラチチュードを持っています。

ラチチュードlatitudeとは?

その前に人間の眼のもつ特性から話したいと思います。

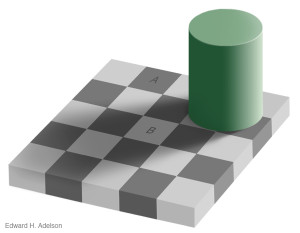

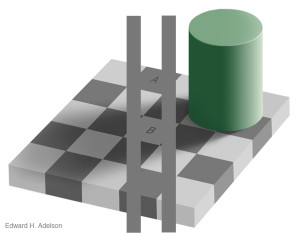

例えば、次の画像を見てください。

人間の眼の特性 視覚の特性

マサチューセッツ工科大学エドワード・エーデルソン「チェッカーシャドー錯視」

この画像の『A』と『B』の明るさはどちらが明るいでしょうか?

『A』 と 『B』 は等輝度であるが、『A』 は 『B』 より暗く見えますよね。

真ん中の正方形の明るさは、対比する隣接する明るさとの差で感じているのです。

差があるほど明るい(暗い)と感じるが、実際には同じです。

私たちの目=肉眼が いかに曖昧であるかがお判りいただけたでしょうか?

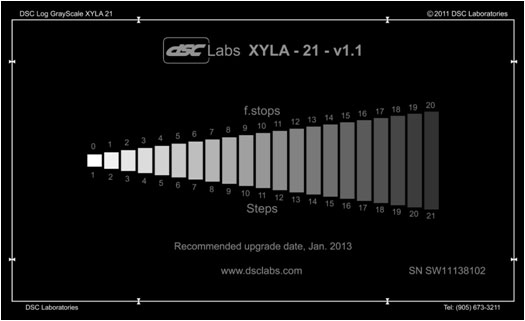

Dynamic Range ダイナミックレンジ

ダイナミックレンジとは?

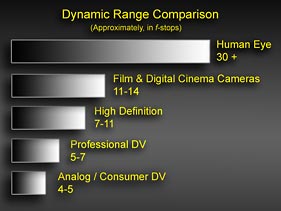

ダイナミックレンジとは明るさの範囲を表します。つまりダイナミックレンジが広いとは暗いところから明るいところまでの範囲が広いということで、狭いとはその逆を意味します。ですから、ダイナミックレンジが広いカメラはその性能が良いと言えます。

私たちはダイナミックレンジを数値化するときに”Stop”という単位を使います。

“Stop”とは”F値”と呼ばれるレンズを通過する光量を制限する絞りを数値化したものです。これはレンズの焦点距離と絞りの直径の比で表されます。

F値 = 焦点距離(mm) / 絞りの直径(mm)

レンズの絞り値は、f/1、f/1.4、f/2、f2.8、f/4、f/5.6、f/8、f/11、f11、f16、f/22といった数値で表されますが、これは2の累乗の平方根です。言い換えれば、光の強さの対数表示になります。

ちなみに人間の眼のF値は1.0と言われています。

人間の眼のダイナミックレンジは30ステップ以上とされていますが、実はフィルム(カメラ)は15ステップくらいあります。それに対してHDのカムコーダーカメラは10ステップ前後、民生のビデオカメラは7ステップ程度しかありません。それに対してデジタルシネマカメラはどうでしょうか。初期のシネマカメラはHDのカムコーダーレベルでしたが、デジタルシネマカメラはようやく12から14ステップになろうとしています。

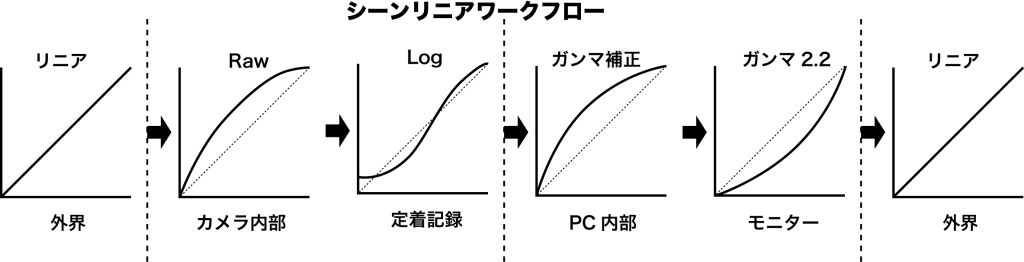

LogとRAWでは、データ記録の考え方も全く異なります。Logは、イメージセンサーの映像に対しLogの性質を持つカーブをあてることによって、高輝度な部分を圧縮して記録していますが、RAWではガンマカーブをあてることなくリニア情報として記録します。そのぶん、階調を16bit採ることで、より広い階調を実現しているわけです。RAWでの記録は、どうしてもファイルサイズが大きくなります。

RAWデータは、無圧縮か可逆圧縮であるためJPEGと比較すると非常に大きなファイルサイズ

RAW形式のデータをJPEG形式に現像処理

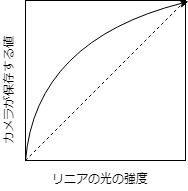

入力値と出力値が直線の関係を示す場合、ガンマ値は1 (γ=1) となるが、ガンマが1.0以下の場合は黒の浮いた出力に、ガンマが1.0以上の場合は黒の潰れた出力になります。例えば、ガンマ値2.2のディスプレイで適正に表示される画像をガンマ値1.8のディスプレイに表示した場合、実際のガンマ値はγ=1.8/2.2≒0.82となり、意図したものよりも黒の浮いた(白が飛んだ)画像となります。画像の入力から最終出力までの全体のガンマが1になるよう、適当なガンマ値のカーブに従って画像の階調を補正することをガンマ補正といいます。

多くの画像編集ソフトウェアにはガンマ補正機能が搭載されています。NTSC方式テレビ放送においては、受信側(テレビ)のガンマ値を2.2と想定し、最終的な出力がγ=1の階調になるよう予め送信側でγ=1/2.2(約0.45)のガンマ補正をかけています。 カラーマネージメントシステムで用いられるICCプロファイルには、当該の入出力機器のガンマ値のデータも定義され、対応機器や対応ソフトウェアではこの定義に従ってガンマ補正が行われています。

実写の世界で必ず必要になる知識として色の特性に関する知識があります。特に近年はVFXなどの実写とCGの組み合わせなども増え、実写撮影したものとCGを合成する場面も増えてきました。この章ではデジタルシネマに欠かせないシーンリニアワークフローに関して解説していきたいと思います。

まず理解して欲しいのは、私たちが外界から得ている色、明るさなどの光の特性は肉眼で見ているものとモニターやスクリーンなどに映し出されたものがあります。実はこのふたつの見ているものには大きな違いがあるのです。その辺りから話を進めていきましょう。

モニター(ディスプレイ)の特性

私たちがディスプレイで見ている映像は常にガンマ補正がかかったものを見ています。

NTSC/sRGBの補正は常にガンマ=2.2です。そのためモニターに出す前にガンマ補正(逆ガンマ=1/2.2)をかけています。モニター上でカラーグレーディング、編集作業などをする時は問題ありませんが、マットペインティング、テクスチャー素材取り込みや合成作業などの物理ベースで作業をする時にはこのガンマ補正がかかったまま素材のやりとりをすることは危険です。なぜならCGや合成ソフト内部での物理計算処理はリニアで計算しているからです。そのため『すべての素材をシーンリニアな状態に統一して作業をする』ことで物理的な計算の誤差や間違いを防ぐということが必要になるのです。

次のことだけを覚えておいてください。

・世の中の色がNatural Raw(Tonecurve = 1.0)

・人間の目やカメラはそのままの色を捉えている訳ではない Sencer Dynamics Range

・映像を映し出すモニターも人間に見せるためにガンマ補正をしている Ganma Correction = 2.2

・CGの色計算はリニアなダイナミックレンジをもっている

・そのために実写とCGを合わせるためにはどちらかに色計算方法を統一する必要がある。

・そのための基本的な考え方、概念が シーンリニアワークフロー である。

説明するのはここまでにします。⇦⇦⇦⇦⇦ 正直、説明が難しいんです!

でも、CGやゲームなどのデジタル映像を扱うときに私たちは正しく色や明るさを捉え、計算し、出力しなければならないということだけ忘れないでおいてください。

そして、後半は

私たちのデジタル映像の未来 のはなしです。

みなさんが社会に出るころの映像の世界、エンターテイメントの世界、は果たしてどうなっているんでしょうか?

あるいは、今後10年後、20年後のデジタル映像の世界はどうなっていくのでしょうか?

未来を正確に予測することは難しいと思います。なぜなら、技術とその結果もたらされる映像の世界は刻々と変化し続けているからです。

東京オリンピック開会式は、ドタバタで残念でしたが、東京オリンピック2020開会式 ドローン1800機余り

そのすぐ後に、中国共産党100周年を記念して、深センの竜崗区で5,200機のドローン

中国の最新ドローンショー

株式会社レッドクリフ(REDCLIFF, inc.)

最近気になる面白い技術たち

最新映像として

ニコンクリエイツが手掛けたボリュメトリックとバーチャルプロダクションの融合

これからの映像は実写、ボリュメトリック、バーチャルプロダクション、CG、VFXがシームレスに繋がっていくことになるんでしょうね。しかも限りなくリアルタイムに近い形で。。。

ここでも紹介した映画ですが『王立宇宙軍 オネアミスの翼』(1987) 、この映画に出てくる宇宙ロケットの発射シーン。これはもちろんアニメとしても初めてですが、ここまでの表現を実現したこと自体素晴らしいと思います。

かつて、若者たちが集まって、アニメを作りたいと企画を立てました。その企画はとあるメーカー(バンダイ)に持ち込まれ、そこの取締役の目に留まり長編アニメとして製作がスタートします。初めて作る長編アニメ製作に彼らは自分たちの夢や想いを重ねていったのです。そのアニメこそ伝説的なオリジナル『王立宇宙軍 オネアミスの翼』(1987)です。そしてその長編を作るために出来たアニメ会社が「ヱヴァンゲリヲン」のガイナックスです。この映画に集った若者たちが初めて長編アニメに取り組み、完成させたものです。彼らは当時平均若干27歳。

エクゼクティブ・プロデューサー:山科誠

企画:岡田斗司夫、渡辺繁

プロデューサー:末吉博彦、井上博明

監督・原案・脚本:山賀博之

助監督:赤井孝美、樋口真嗣、増尾昭一

キャラクターデザイン・作画監督:貞本義行

作画監督:庵野秀明、飯田史雄、森山雄治

スペシャルエフェクトアーティスト:庵野秀明

美術監督:小倉宏昌

撮影監督:諫川弘

撮影スーパーバイザー:八巻磐

3DCG:ハイテックラボ・ジャパン

編集:尾形治敏

音響監督:田代敦巳

音楽監督:坂本龍一

脚本協力:大野木寛

設定スーパーバイザー:野田昌宏、江藤巌

デザイン、レイアウト:藤原カムイ

オープニング、エンディングイラスト:大西信之

映画『アポロ13』(1995)これはCG、VFXを駆使して表現されています。VFXを手がけたのはDigitalDomain(米)

映画『宇宙兄弟』(2012)でのロケット発射シーン.

VFXを手掛けたのはオムニバスジャパン(日)日本も頑張っているけど、正直ハリウッドには10年遅れているぞ。。。

本当に最後に、

昨年、『デジタルコンテンツ概論』の中で紹介した私が手掛けたドラマの中のVFXのワンシーンを

もう一度お届けします。この映像論でも紹介したワークフローパイプライン、トラッキング、合成、エフェクト、カメラマッピングなどを

駆使した作品です。改めてみるとどのように作られているかが、わかってくると面白いと思います。

(限定公開)

最後に

私たちは、大学にいて 何かを学んだり、自分の興味関心、視野を広げる日々を送っています。

ぜひ、そのために大学の設備、機材、環境、教員たちをうまく利用するようにいてください。

授業を受けたり、課題やレポートをこなすことだけが、大学では決してありません。

ほとんどの人とはこの授業が最後になります。

でもまたどこかで、一緒に何かを生み出すことが出来るといいな、と思います。

では、皆さん元気で!